fluxgguf与sd3.5对比测评

fluxgguf与sd3.5对比测评

ZHY省流:

在提示词的理解度以及画面的完成方面flux更胜一筹,

从图像的质量来看SD3.5更好(但是3.5不会画手)而且经常人体崩坏。

这两者进行结合也许能做出不错的图片,比如flux生图再经过3.5高清修复。

对比过程

统一提示词

In a warm and comfortable bedroom, sunlight shines through the window onto the soft sheets, bringing a warm color to the entire room. There is a girl lying on the bed, immersed in the peaceful afternoon time, enjoying a moment of laziness. Her face appeared particularly soft under the sunlight, and her long eyelashes trembled gently, as if expressing her inner peace and tranquility. Time seems to stand still at this moment, making people slow down and immerse themselves in this simple and pure beauty,This girl is wearing red clothes,The girl turned her face to the camera |

| Flux | SD3.5 | |

|---|---|---|

| 大模型 | flux1-dev-Q4_1 | SD3.5_medium |

| clip | t5-v1_1-xxl-encoder-Q4_K_M,clip_l | t5xxl_fp8_e4m3fn_scaled,clip_l |

| 辅助lora | Hyper-FLUX.1-DEV-8steps-lora | 无 |

| 第二次生成时间 | 50.98s | 45.02s |

| 效果图(仅展示最新一张) |  |

(看着挺吓人的) |

Flux-gguf

我使用的是flux1-dev-Q4_1.gguf模型,符合我8g显存的配置clip的t-5xxl模型也是采用Q4版本的。

其中还使用了字节跳动发布的Hyper-FLUX.1-DEV-8steps-lora,出图更快,配合该lora步数需要控制在8步。还有个16步的版本,看不出太大区别,生成需要时间更长点,步数要换到16。

SD3.5_medium

我使用的是SD3.5的中杯medium模型

使用方法:

添加一个模型采样算法偏移节点,数值在2-3之间最好,可以增加清晰度。

步数 要在28以上

cfg 4-5之间

从出效果图来看…不是很听话。生了几张图,能用的很少。

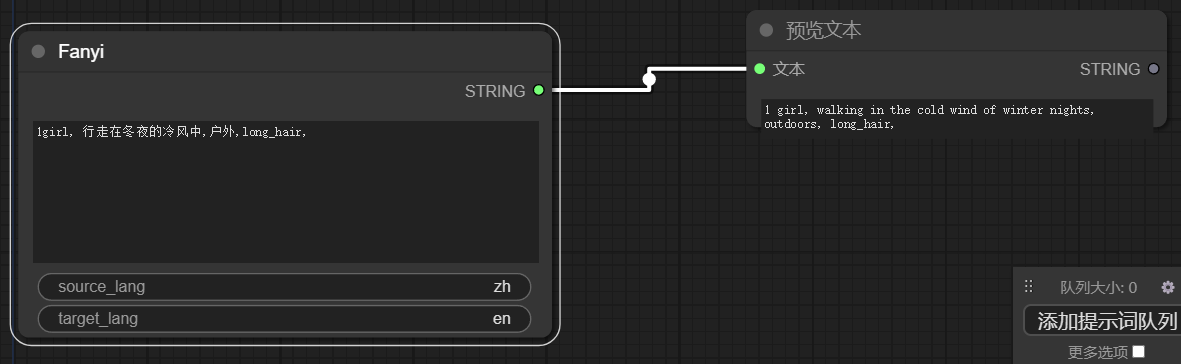

两者结合

由flux1-dev-Q4_1.gguf生成1024px的原图,

先通过模型放大四倍,再缩小到特定像素,再进行图生图。使用SD3.5_medium

用时114.84s,接近两分钟。比先缩小图再模型放大传入的图生图要更快一些,质量目测也更好一些。